Twitter API v2の使い方

Twitter API v2は大きく分けると2つ、

ツイート

ユーザー

2つの情報が取得できる。

以前はツイート検索をしたかったためツイート取得機能を使用した。

今回はユーザー情報に関する以下の機能を試す。

| 機能 | 説明 |

|---|---|

| User lookup | ユーザー名かユーザーIDからユーザーを検索する |

| Follows lookup | ユーザーIDからフォローしてる・されてる人を取得する |

| Manage follows | ユーザーIDからフォロー・フォロー解除を行う |

公式から引っ張ってきただけ。

https://developer.twitter.com/en/docs/twitter-api/early-access

1. 実験

Twitter API v2を使用して任意のユーザーアカウントの情報に加えて、フォロワーのユーザー情報を取得する。

ソースコードは後述する。

またTwitter API自体の使い方については以下の記事に書いてある。

- 実験対象

自分のTwitterアカウントで実験する。

1.1. User lookup

User lookupの機能を使うとユーザー名かユーザーIDからユーザーを検索して、その情報を取得できる。

勘違いしやすいがTwitterには名前(name)とユーザー名(username)の両方が存在する。

@の後に続くものをユーザー名と呼ぶ。

ユーザーID(id)に関してはプロフィール上には表示されず変更もできない。

User lookupにより取得できるユーザー情報について、

このアカウントのユーザー名「@CircleKENdotNet」から得た情報を例として以下の表により説明する。

| 種類 | 型 | 説明 | 例 |

|---|---|---|---|

| id | string | ユーザーのID | 4790312834 |

| name | string | ユーザーの名前 | KEN |

| username | string | ユーザーの名前(@の後のやつ) | CircleKENdotNet |

| created at | date (ISO 8601) | アカウント作成時刻 | 2016-01-20T 20:43:52.000Z |

| protected | boolean | 鍵アカウントかどうか | FALSE |

| withheld | object | 地域の法律により表示が差し控えられているプロフィールの詳細 | |

| location | string | 地域 | |

| url | string | url | URL省略 |

| description | string | 自己紹介欄(bioとも呼ばれる) | 「プリティーシリーズ」の新アニメ「キラッとプリ☆チャン」 4月8日より毎週(日)ごぜん10:00~テレビ東京系6局ネット、 毎週(火)ゆうがた17:29~BSジャパンにて放送! |

| verified | boolean | 公式アカウントかどうか | FALSE |

| entities | object | 埋め込まれているurlの情報 | {‘url’: {‘urls’: [{‘start’: 0, ‘end’: 23, ‘url’: ‘URL省略’, ‘expanded_url’: ‘URL省略’, ‘display_url’: ‘URL省略’}]}} |

| profilel image url | string | プロフィール画像 | URL省略 |

| public metrics | object | フォロー数、フォロワー数、ツイート数、リストに入っている数 | {‘followers count’: 780, ‘following_count’: 0, ‘tweet_count’: 41, ‘listed_count’: 7} |

| pinned tweet id | string | 固定ツイートのツイートID |

「location」は住んでる場所を登録してないので空欄。

プロフィール上に表示される情報以外にも「id」や「listed_count(リストに入れられている数)」など普段見えない数字も見える。

なぜかヘッダー画像は取得できない。

1.2. Follows lookup

Follows lookupの機能を使うとユーザーIDからユーザーを検索して、そのユーザーのフォローしてる人かされてる人のユーザー情報を取得できる。

取得できるユーザー情報はさっきのUser lookupにより取得できる情報と同じ。

ユーザーIDが分かればいいので、別に自分のアカウントでなくとも任意のアカウントのフォロワーの情報が取得できる。

これによって780人のフォロワー分の情報が取得できた。

2. コード

Twitter API v2によりユーザー情報を取得してCSVファイルに保存するコード。

2.1. User lookup

1 | import requests |

2.2. Follows lookup

フォロー、フォロワーの取得は1リクエストにつき最大1000件までしか返ってこないのでnext_tokenというものを受け取って続きから再リクエストする必要がある。

以下のコードはその辺も組み込んで一度に1001以上のユーザー情報を取得できるようにしてある。

15分あたり300リクエストまで許されるので30万件までなら一度に取得できる。

1 | import requests |

3. Twitter API リンク

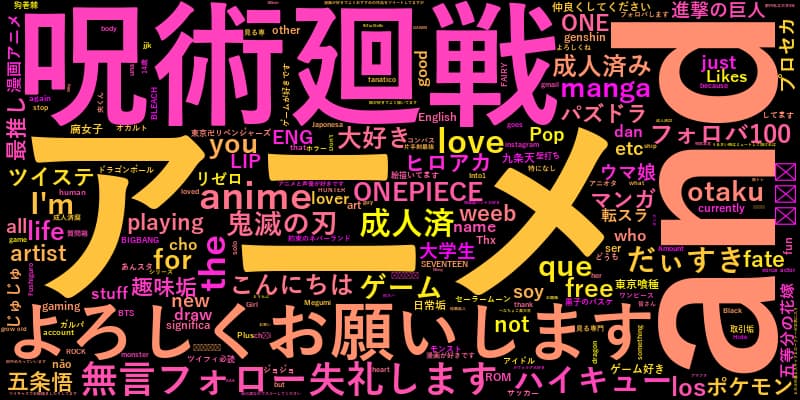

![Twitter API v2の使い方5[フォロワードクラウド]](/../images/post61_003.jpg)

![Twitter API v2の使い方6[コウメ太夫氏の#まいにちチクショーを取得する]](/../images/koume.jpg)